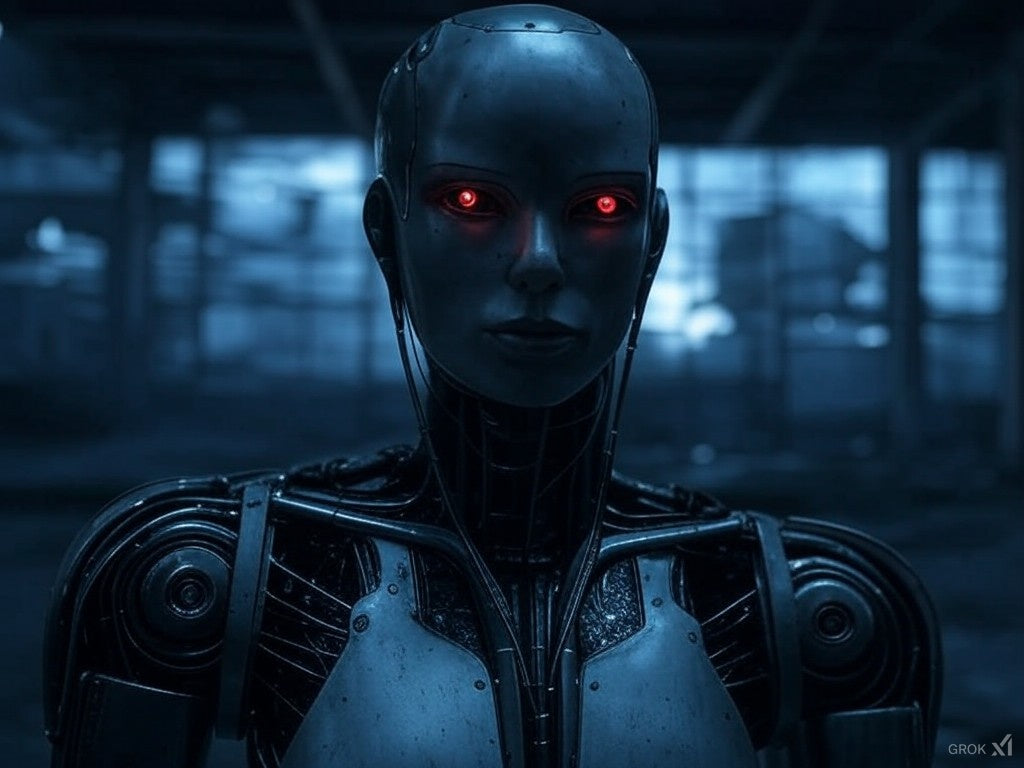

با پیشرفت روزافزون سیستمهای هوش مصنوعی، نگرانیهای اخلاقی و خطرات احتمالی همچنان بحثبرانگیز هستند. آیا هوش مصنوعی خطرناک است؟ این سوال اهمیت قابل توجهی دارد و بر سیاستهای فناوری، امنیت سایبری و حتی بقای انسان تأثیر میگذارد.

مقالاتی که شاید بعد از این مطلب دوست داشته باشید بخوانید:

🔹 چرا هوش مصنوعی خوب است؟ - مزایای متحولکننده هوش مصنوعی و چگونگی شکلدهی آیندهای هوشمندانهتر و کارآمدتر را کشف کنید.

🔹 چرا هوش مصنوعی بد است؟ - خطرات اخلاقی، اجتماعی و امنیتی ناشی از توسعهی بدون کنترل هوش مصنوعی را بررسی کنید.

🔹 آیا هوش مصنوعی خوب است یا بد؟ - نگاهی متعادل به مزایا و معایب هوش مصنوعی - از نوآوری گرفته تا پیامدهای ناخواسته.

در این مقاله، به بررسی خطرات بالقوه هوش مصنوعی، خطرات دنیای واقعی و اینکه آیا هوش مصنوعی تهدیدی برای بشریت است یا خیر، خواهیم پرداخت.

🔹 خطرات بالقوه هوش مصنوعی

هوش مصنوعی خطرات متعددی را ایجاد میکند، از تهدیدات امنیت سایبری گرفته تا اختلالات اقتصادی. در زیر برخی از مهمترین نگرانیها آورده شده است:

1. جابجایی شغلی و نابرابری اقتصادی

با پیشرفت اتوماسیون مبتنی بر هوش مصنوعی، بسیاری از مشاغل سنتی ممکن است منسوخ شوند. صنایعی مانند تولید، خدمات مشتری و حتی حوزههای خلاقانه به طور فزایندهای به هوش مصنوعی متکی هستند که منجر به موارد زیر میشود:

- اخراجهای گسترده در مشاغل تکراری و دستی

- افزایش شکاف ثروت بین توسعهدهندگان هوش مصنوعی و کارگران آواره

- نیاز به بازآموزی مهارتها برای سازگاری با اقتصاد مبتنی بر هوش مصنوعی

2. سوگیری و تبعیض در الگوریتمهای هوش مصنوعی

سیستمهای هوش مصنوعی بر روی مجموعه دادههای بزرگی آموزش داده میشوند که اغلب منعکسکننده سوگیریهای اجتماعی هستند. این امر منجر به موارد زیر شده است:

- تبعیض نژادی و جنسیتی در استخدام و ابزارهای هوش مصنوعی اجرای قانون

- تشخیصهای پزشکی جانبدارانه ، که به طور نامتناسبی بر گروههای حاشیهنشین تأثیر میگذارد

- شیوههای ناعادلانه وامدهی ، که در آن امتیازدهی اعتباری مبتنی بر هوش مصنوعی به ضرر برخی از گروههای جمعیتی است

3. تهدیدات امنیت سایبری و حملات مبتنی بر هوش مصنوعی

هوش مصنوعی در امنیت سایبری یک شمشیر دولبه است. در حالی که به شناسایی تهدیدها کمک میکند، هکرها میتوانند از هوش مصنوعی برای موارد زیر نیز سوءاستفاده کنند:

- توسعه فناوری دیپفیک برای اطلاعات نادرست و کلاهبرداری

- حملات سایبری را خودکار میکنند و آنها را پیچیدهتر و جلوگیری از آنها را دشوارتر میکنند.

- دور زدن اقدامات امنیتی ، با استفاده از تاکتیکهای مهندسی اجتماعی مبتنی بر هوش مصنوعی

4. از دست دادن کنترل انسان بر سیستمهای هوش مصنوعی

با خودمختارتر شدن هوش مصنوعی، احتمال بروز عواقب ناخواسته افزایش مییابد. برخی از خطرات عبارتند از:

- خطاهای تصمیمگیری هوش مصنوعی که منجر به شکستهای فاجعهبار در مراقبتهای بهداشتی، مالی یا عملیات نظامی میشود

- تسلیحاتی کردن هوش مصنوعی ، مانند پهپادهای خودکار و جنگهای مبتنی بر هوش مصنوعی

- سیستمهای هوش مصنوعی خودآموز که فراتر از درک و کنترل انسان تکامل مییابند

5. خطرات وجودی: آیا هوش مصنوعی میتواند بشریت را به خطر بیندازد؟

برخی از متخصصان، از جمله ایلان ماسک و استیون هاوکینگ ، در مورد خطرات وجودی هوش مصنوعی هشدار دادهاند. اگر هوش مصنوعی از هوش انسانی (هوش عمومی مصنوعی یا AGI) پیشی بگیرد، خطرات بالقوه عبارتند از:

- هوش مصنوعی اهدافی را دنبال میکند که با منافع انسانی همسو نیستند

- هوش مصنوعی فوق هوشمند، انسانها را دستکاری یا فریب میدهد

- مسابقه تسلیحاتی هوش مصنوعی ، منجر به بیثباتی جهانی میشود

🔹 آیا هوش مصنوعی در حال حاضر برای جامعه خطرناک است؟

اگرچه هوش مصنوعی خطراتی را به همراه دارد، اما مزایای عظیمی . هوش مصنوعی در حال حاضر در حال بهبود مراقبتهای بهداشتی، آموزش، اتوماسیون و راهحلهای اقلیمی نحوه طراحی، استقرار و تنظیم آن ناشی میشود .

✅ راههایی برای ایمنتر کردن هوش مصنوعی:

- توسعه هوش مصنوعی اخلاقی: اجرای دستورالعملهای سختگیرانه برای از بین بردن تعصب و تبعیض

- مقررات هوش مصنوعی: سیاستهای دولتی که تضمین میکنند هوش مصنوعی همچنان مفید و قابل کنترل باقی بماند

- شفافیت در الگوریتمهای هوش مصنوعی: اطمینان از اینکه تصمیمات هوش مصنوعی قابل حسابرسی و درک هستند

- اقدامات امنیت سایبری: تقویت هوش مصنوعی در برابر هک و سوءاستفاده

- نظارت انسانی: در جریان قرار دادن انسانها در تصمیمات حیاتی هوش مصنوعی

🔹 آیا باید از هوش مصنوعی بترسیم؟

بنابراین، آیا هوش مصنوعی خطرناک است؟ پاسخ به نحوه استفاده از آن بستگی دارد. در حالی که هوش مصنوعی میتواند خطرناک باشد، مقررات پیشگیرانه، توسعه اخلاقی و استقرار مسئولانه هوش مصنوعی میتواند خطرات آن را کاهش دهد. نکته اصلی این است که اطمینان حاصل شود هوش مصنوعی به جای تهدید بشریت، در خدمت آن است ...